G検定とは

一般社団法人日本ディープラーニング協会(JDLA)が実施する資格試験。

小僧が受験するのはG検定で合格できたものはJDLAより下記の認定を受け取ることができる。

ディープラーニングの基礎知識を有し、適切な活用方針を決定して事業応用する能力を持つ人材

今回も前回~part3~に引き続きG検定受験にむけた内容をメモしていきたいと思います。

K-means

教師なし学習は入力データにある構造や特徴をつかむためのもので、K-meansと呼ばれる手法はデータをK個のグループに分けることを目的としている

ただしこのK個はKは自分で設定する必要がある

クラスタ(cluster)

K個のグループのことをクラスタと呼び、K-meansを用いた分析のことをクラスタ分析とよぶ

k-meansのアプローチ

- 適当にデータをk個のクラスタに振り分ける

- 各クラスタの重心を求める

- 求まった重心と各データとの距離を求め、各データに最も距離が近い重心に対応するクラスタに振り分け直す

- 重心の位置が変化しなくなるまで2~3点目を繰り返す

主成分分析(Principal Component Analysis, PCA)

PCAはデータの特徴量の相関関係を分析することでデータの構造をつかむ手法

特徴量数が多い場合に用いられ、相関をもつ多数の特徴量から、相関のない少数の特徴量へと次元削減することが主たる目的

ここで得られる少数の特徴量を主成分という

次元削減することのメリット

機械学習で用いる特徴量は次元が多くなりがちだが、次元削減をすることで、学習にかかる時間を減らしたり、あるいわデータを可視化することができる

機械学習の目的

機械学習では手元のデータを学習することによってデータの特徴を掴み、未知のデータが与えられた際にどんなパターンになるかを識別・予測できるようになること

手法の評価

機械学習の目的にならい手法を評価する場合でも未知のデータに対して予測能力を検証することが必要、しかし前述の通り未知のデータのため準備が困難であるため擬似的にデータを用意する必要がある

データの利用方法

手法の評価では未知のデータを準備することが難しいため、予め用意できるデータを学習用データと、評価用データにランダムに分割して評価する。

分割してデータのうち学習用データを訓練データ、評価用のデータをテストデータと呼ぶ。またこのようにデータを分割して評価をすることを交差検証という

また訓練データを更に分割し、訓練データと検証データに分割する場合がある。

この時、検証データで一度モデル評価を行いパラメータを調整し、テストデータを用いて最終的なモデルの評価を行う流れになる

交差検証の種類

訓練データ・テストデータの分割を複数回行い、それぞれで学習・評価を行うアプローチ

※写真はこちらより引用

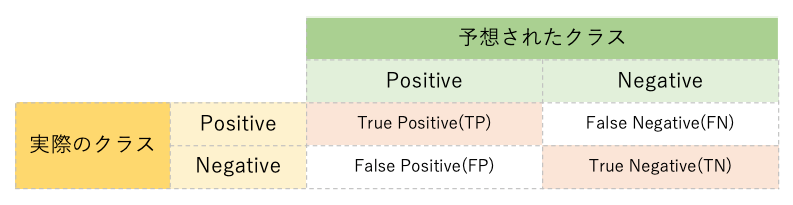

混同行列(Confusion Matrix)

混同行列とは、クラス分類の結果をまとめた表のこと

陽性のサンプルのうち、何個が正しく陽性と判定され、何個が誤って陰性と判定されたか、といったことを分かりやすくまとめるために用いる

正解率(Accuracy)

全データ中どれだけ予測が当たったかの割合

正解率(Accuracy)=(TP+TN)/(TP+FP+TN+FN)

適合率(Precision)

予測の中で実際に正であったものの割合

適合率(Precision) = TP / (TP + FP)

再現率(recall)

実際に正であるものの中で正だと予測できた割合

再現率(recall)= TP / (TP + FN)

F値(F measure)

適合率と再現率の調和平均

適合率または再現率のみで判断すると、予測が偏っている時も値が高くなってしまうので、F値を用いるケースが多い

F値(F measure) = (2 × precision × recall) / (precision + recall)

オーバーフィッティング

訓練データでは良い性能が出るが、テストデータでは性能が悪くなってしまうこと

正則化

学習の際に用いる式に項を追加することによって取りうる重みの値の範囲を制限し、過度に重みが訓練データに対してのみ調整されることを防ぐ役割を果たす。

アンダーフィッティング

正則化をしすぎて全体の予測性能が低下してしまうこと

L1正則化

一部のパラメータの値をゼロにすることで、特徴選択を行うこと

L2正則化

パラメータの大きさに応じてゼロに近づけることで、汎化されたなめならかなモデルを得ること

|

|

Know Easy

Know Easy

![[商品価格に関しましては、リンクが作成された時点と現時点で情報が変更されている場合がございます。] [商品価格に関しましては、リンクが作成された時点と現時点で情報が変更されている場合がございます。]](https://hbb.afl.rakuten.co.jp/hgb/1804a342.334a3c66.1804a343.381802a7/?me_id=1213310&item_id=19303728&m=https%3A%2F%2Fthumbnail.image.rakuten.co.jp%2F%400_mall%2Fbook%2Fcabinet%2F7559%2F9784798157559.jpg%3F_ex%3D80x80&pc=https%3A%2F%2Fthumbnail.image.rakuten.co.jp%2F%400_mall%2Fbook%2Fcabinet%2F7559%2F9784798157559.jpg%3F_ex%3D240x240&s=240x240&t=picttext)